A continuación, compartimos con todos Uds. un resumen de las novedades más destacadas del mundo de la ciencia y la tecnología.

El robot que aterrizó en el cometa

mandó una foto

mandó una foto

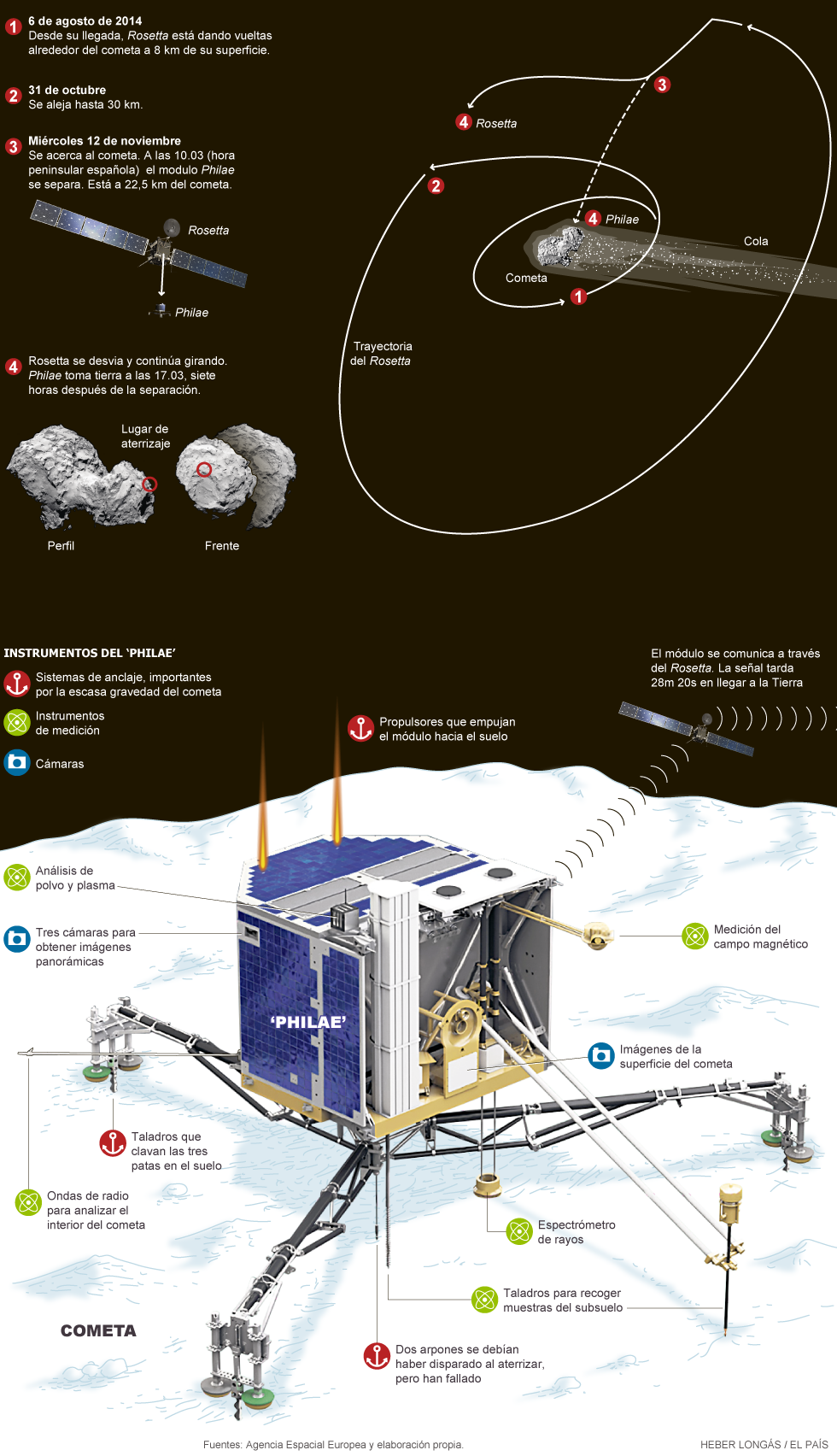

El miércoles 12 de noviembre de 2014 un módulo robótico se posó en un cometa y ahora el grupo de científicos de la Agencia Espacial Europea (ESA) lo siguen como si fuera un bebé recién nacido que requiere una atención especial. Estamos hablando del módulo Philae que logró acometizar sobre la superficie del cometa 67P/Churymov-Gerasimenko.

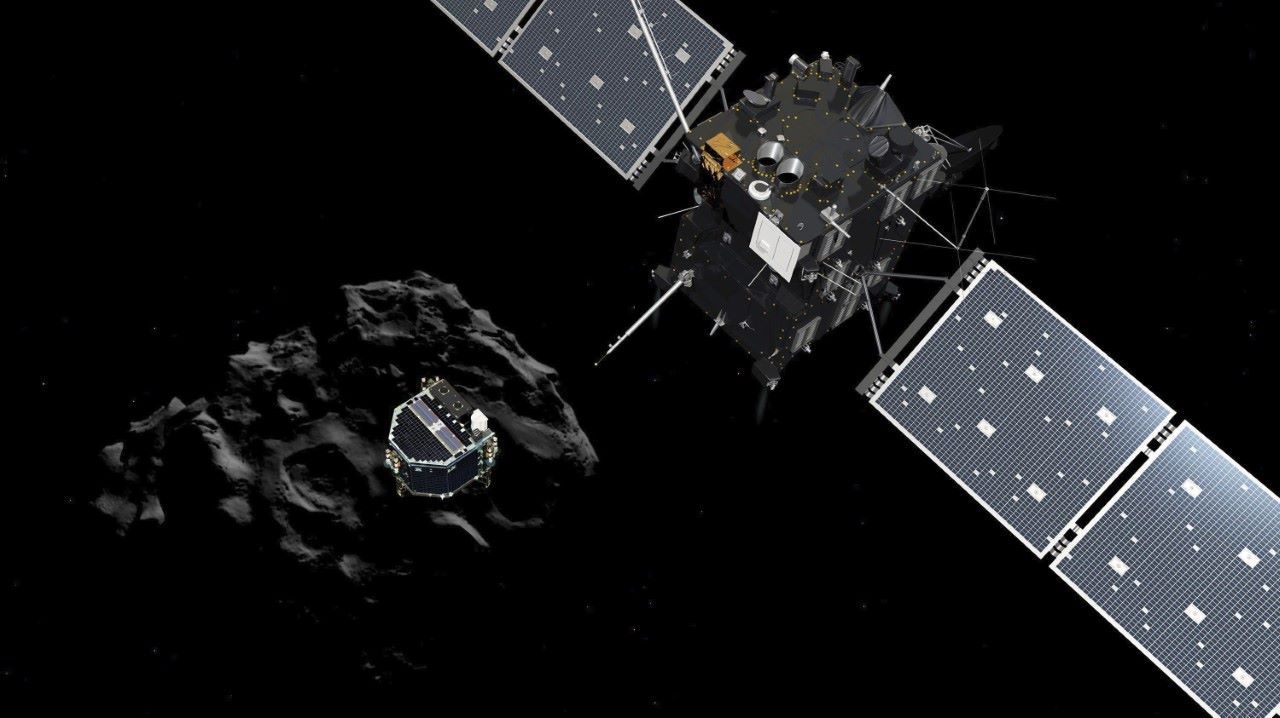

El aterrizaje del módulo, que fue liberado desde la sonda Rosetta que orbita al cometa y fue lanzada diez años atrás, fue considera una hazaña histórica en la exploración espacial.

Una de las preocupaciones de los científicos es que cuando el módulo Philae aterrizó no se desplegaron los arpones que debían anclarlo con la superficie del cometa. Sin embargo, ayer la agencia espacial informó que el módulo "está asegurado en la superficie", tras observar las dos primeras imágenes que tomó otro de sus instrumentos, que funciona con cámaras en infrarrojo. Está parado sobre dos de sus tres patas, pero se encuentra "estable" y ya produjo datos.

Ayer también los investigadores pudieron tener acceso a la información sobre cómo fue el aterrizaje del miércoles. En realidad, el módulo aterrizó 3 veces en el lugar elegido del cometa, bautizado Agilkia. Primero rebotó, dio un salto, volvió a posarse y rebotó de nuevo dando un brinco más pequeño. En total, pasaron dos horas hasta que finalmente el módulo se quedó parado en el suelo, aproximadamente a un kilómetro del primer punto de aterrizaje. Philae pesaba 100 kilos en la Tierra, pero sólo un gramo en el cometa, con su escasa atracción gravitatoria. Según el jefe del módulo Philae, "todavía no tenemos claro dónde estamos exactamente ahora", pero seguirán analizando los datos que la sonda manda.

Dado que Philae se depositó cerca de una colina que le genera sombra los esfuerzos de los equipos instrumentales deben estar abocados a mejorar la situación para que reciba radiación solar y recargue sus baterías. Si no se logra eso, se impondrá una fuerte restricción en el tipo ciencia que se puede llevar a cabo en la superficie del cometa.

Fuente: Clarín

El cometa en el que aterrizó Philae

es duro como el hielo

es duro como el hielo

La Agencia Espacial Europea (ESA) informó que el cometa 67/P Churyumov-Gerasimenko es duro como el hielo y tiene moléculas orgánicas que son analizadas para ser identificadas. Estos son los primeros resultados de los experimentos científicos del módulo Philae.

La ESA informó que la misión de la sonda madre Rosetta continúa tras el aterrizaje del pequeño laboratorio Philae, que desde el sábado 15/11 está en estado de reposo porque no recibe suficiente luz del Sol para cargar sus paneles solares.

Sin embargo -añadió la ESA- la batería que llevaba a bordo, con autonomía para dos días, le permitió hacer algunos descubrimientos importantes con sus diez instrumentos a una distancia de 511 millones de kilómetros. El módulo Philae trabajó más de 60 horas sin interrupción y mandó los datos a la sonda madre Rosetta en cada posibilidad de comunicación.

Para los científicos la superficie del cometa 67/P Churyumov-Gerasimenko es muy diferente a lo que pensaban hasta ahora. La sonda termal Mupus no pudo martillear la superficie del cometa debido a su dureza.

El taladro SD2, el último de los diez instrumentos que se activó, realizó pruebas en el suelo y descubrió las primeras moléculas orgánicas, que todavía son analizadas. Rosetta, que acompañará al cometa hasta el final del año próximo cuando se acerque al Sol, proporciona el 80 % de los datos científicos y Philae cubrirá el 20 % restante.

Por ejemplo, Rosetta ya detectó que el cometa emite vapor de agua: en julio, cuando el cometa se encontraba a 583 millones de kilómetros, dos vasos pequeños de agua por segundo y en septiembre aumentó hasta 1 litro por segundo.

Los cometas son los cuerpos celestes más antiguos del Universo y se considera que pudieron haber traído el agua y la vida a la Tierra en el momento de la gran explosión.

Fuente: Clarín

El Philae se quedó sin energía

El módulo Philae finalmente agotó sus baterías y por ahora entró en modo "reposo" sobre la superficie del cometa. Y aún no se sabe cuándo podrá volver a despertar. "Con sus baterías agotadas y sin suficiente luz solar para recargarlas, Philae ha entrado en modo reposo para un silencio potencialmente largo", explicó el sábado 15/11 la Agencia Espacial Europea (ESA).

Antes de entrar en este estado, que implica que todos sus instrumentos y la mayoría de sus sistemas están apagados, el módulo pudo transmitir valiosos datos científicos sobre el cometa 67/P Churyumov-Gerasimenko.

Luego de haber perdido contacto con Philae debido al agotamiento de las baterías recargables, "a partir de ahora no será posible contacto alguno a menos que los paneles solares de Philae reciban suficiente luz solar para generar la energía necesaria para despertarlo", insistió la ESA.

Fuente: Clarín

Galería fotográfica

Por qué es tan importante llegar a un cometa

"Es un poco como Cristóbal Colón llegando a América. No se sabe con qué se va a topar", aseguró desde desde el centro de operaciones de la Agencia Espacial Europea (ESA) de Darmstadt, en Alemania, Roger-Maurice Bonnet.

Philae, el robot de Rosetta que se posó sobre el cometa, intentará "aportar un mejor conocimiento sobre los elementos sólidos de este cometa". Para el experto, "la misión es casi perfecta" porque "ya cumplió muchas cosas con las que soñaban los científicos" y comentó que lo más "extraordinario" es su desafío técnico.

Bonnet, que era director del programa científico de la ESA cuando se lanzó Rosetta en 2004, aseguró que en aquel entonces jamás se imaginó que se posaría sobre un cometa y que para él se trata de la culminación de un programa que comenzó hace cerca de 20 años.

"Esto es ya es un éxito impresionante, porque nadie hubiese imaginado que este cometa era tan espectacular, ni tan rico en información. Pienso que esta misión fue optimizada y estoy orgulloso, porque logré que quepa dentro de un presupuesto limitado. Eso obligó a la gente a optimizar sus objetivos científicos y a simplificar sus experiencias o recurrir a tecnologías o sistemas más habilidosos", comentó.

Al principio, la misión no se llamó Rosetta y aspiraba a traer de regreso a la Tierra muestras de restos de polvo de cometa, pero el plan a 20 años tenía limitaciones. "Se necesitaba un paracaídas, infraestructura marina para recuperar la muestra y construir un laboratorio especial para analizarla", comentó Bonnet. Y fue ese motivo que los científicos decidieron enviar instrumentos al espacio y realizar los análisis "in situ". "Fue allí que nació la idea de enviar un módulo capaz de posarse en el núcleo de un cometa", recordó el científico.

¿Cuál es el objetivo final del proyecto? Estas muestras de materia orgánica del cuerpo celeste podrían encerrar las claves para comprender la aparición de la vida en la Tierra y monitorear in situ los cambios que el cuerpo sufre en su viaje hacia el Sol, particularmente las transformaciones que le provoca el aumento de la radiación solar.

"Los cometas son los objetos más primitivos del Sistema Solar. Vivieron la inmensa mayoría de sus vidas muy lejos del Sol", explicó el astrofísico Francis Rocard, que colabora en la misión. "La materia que los compone no se calentó y por esa razón no se modificó; guardamos en el congelador durante casi 4.560 millones de años la materia original que formó los planetas", aclara. Los cometas son cuerpos ricos en gases congelados, entre ellos el agua. Por eso, el origen de la vida en la Tierra podría explicarse por el impacto de estos cuerpos errantes. "Estos cuerpos son también los objetos más ricos en carbono, cuya parte refractaria -es decir la que permanece en estado sólido a la temperatura actual del cometa- presenta una forma molecular desconocida. Estas cadenas carbonadas complejas nos interesan porque se necesita una química orgánica compleja para fabricar la vida", amplió Rocard.

Fuente: Clarín

Información adicional

Algunos datos sobre la Misión Rosetta.

Datos sobre el cometa 67/P:

- Rotación 67/P: 12,4 horas.

- Masa: 10.000 millones de toneladas

- Densidad: 400 kilos por metro cúbico (similar a algunas maderas)

- Volumen: 25 kilómetros cúbicos

Qué hay a bordo de Philae

1 Cámaras: Philae tiene un sistema de cámaras CIVA que tomará fotos panorámicas de la superficie del cometa. El sistema ROLIS espiará el descenso del cometa, y tomará varios primeros planos una vez que aterrice.

2 Núcleo de la sonda: CONSERT utilizará ondas de radio para conocer la estructura interna del cometa.

3 Patas taladro: Taladros para hielo que están adaptados a las patas de Philae, y le permitirán aferrarse a la superficie. Este mecanismo puede perder eficacia si el terreno es muy suave o muy duro.

4 Taladro para tomar muestras: SD2 (mecanismo de recolección y distribución). Perforará a una profundidad un poco mayor de 20 centímetros para recolectar muestras y entregarlas a los laboratorios internos COSAC y PTOLEMY para su análisis.

5 Arpones: inmediatamente después del aterrizaje, Philae dispara arpones que cumplirán las funciones de anclas, y así prevenir rebotes por la falta de gravedad.

6 Sonda de superficie MUPUS: Sensores colocados en las anclas del robot comprobarán la densidad y propiedades térmicas de la superficie y debajo de la misma.

Cómo continúa la misión

Después de la secuencia inicial, están planeados otros estudios a largo plazo, dependiendo de qué tan bien se puedan recargar las baterías. Eso podría verse afectado incluso por la cantidad de polvo que acumulen sus paneles solares.

Según continúa la misión y el cometa se acerca al Sol, las temperaturas dentro del módulo empezarán a subir tanto que los sistemas dejarán de funcionar. Pero después de que termine la misión de Philae, Rosetta seguirá escoltando y analizando al cometa unos pocos meses.

Noviembre 2014: primera secuencia de experimentos. Luego del aterrizaje sobre el cometa, Philae pasará los primeros días realizando experimentos prediseñados en sus sistemas.

Diciembre 2014: experimentos de largo plazo. El equipo espera que Philae pueda recargar sus baterías y así mantenerse operativo realizando observaciones a pesar de los cambios de temperatura que sufra el cometa.

Marzo 2015: fecha límite. Para esta fecha se espera que Philae pueda verse afectado por el aumento de la temperatura en el cometa, así como por la acumulación de polvo sobre los paneles solares que le sirven de batería.

Agosto 2015: perihelio. El cometa alcanzará el punto más cercano al Sol. Rosetta estará midiendo el nivel de actividad cuando la estructura de hielo del cometa alcance su fase más activa.

Fuente: BBC Mundo